9月22日消息,在昨晚的GTC 2022大会(上下半年各一次),NVIDIA不仅发布了RTX4080/4090系列显卡,还宣布了一件事,那就是3月份发布的计算卡H100终于开始出货,也是10月份开始上市。

换言之,英伟达NVIDIA H100 Tensor Core GPU全面投产,NVIDIA全球技术合作伙伴计划于10月推出首批基于开创性NVIDIA Hopper架构的产品和服务。

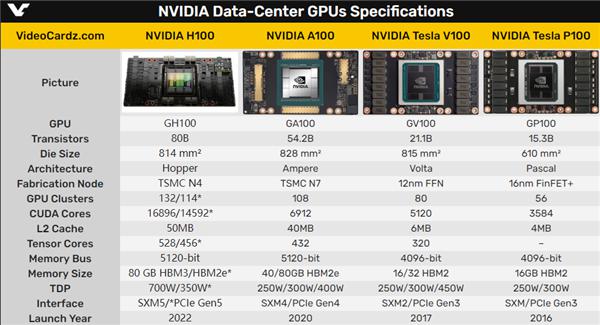

实际上,H100加速卡今年3月份的GTC大会上发布,距今刚好半年了,采用Hopper架构,GH100大核心,台积电4nm制造工艺、CoWoS 2.5D封装技术,集成800亿个晶体管,核心面积814平方毫米。

据悉,它拥有18432个CUDA核心、576个Tensor核心、60MB二级缓存,支持6144-bit位宽的六颗HBM3/HBM2e,支持PCIe 5.0,支持第四代NVLink总线。

来源:网络

另外,H100计算卡有SXM、PCIe 5.0两种样式,其中SXM版本15872个CUDA核心、528个Tensor核心,PCIe 5.0版本14952个CUDA核心、456个Tensor核心,功耗最高达700W。

编者也了解到,关键的是,H100使企业能够削减AI的部署成本,相较于上一代,在提供相同AI性能的情况下,可将能效提高3.5倍,总体拥有成本减少至1/3,所使用的服务器节点数也减少至1/5。

可喜的是,NVIDIA DGX H100系统现在也已开始接受客户预定。该系统包含8个H100 GPU,FP8精度的峰值性能达到32PFlops。每个DGX系统都包含NVIDIA Base Command和NVIDIA AI Enterprise软件,可实现从单一节点到NVIDIA DGX SuperPOD的集群部署,为大型语言模型和其他大规模工作负载的高级AI开发工作提供支持。

对于需求方最关心的问题,H100的价格没有官方消息,不过之前日本市场有过预售,PCIe版本的都要475多万日元,人民币要24万元以上了,SXM版价格应该会更贵。

但也有最新消息显示,H100加速卡10月份上市,其中亚马逊、谷歌及微软三大云服务供应商会率先采用,还有就是科研机构及高校,洛斯阿拉莫斯国家实验室和瑞士国家超级计算中心、日本筑波大学也会采购。

另一方面,全球领先的计算机制造商所提供的搭载H100的系统预计将在未来几周内发货,到今年年底将有超过50款服务器型号面市,2023年上半年还将有数十款型号面市。已在构建系统的合作伙伴包括源讯(Atos)、思科、戴尔科技、富士通、技嘉科技、慧与、联想和超微。

回顾数日前(9月19日),据中国台湾省《经济日报》报道,全球GPU龙头英伟达近期对台积电下了“超级急件(super hot runs)”订单,以提前生产原计划明年出货的部分产品。传闻称,这批“超级急件”涉及5000片晶圆产能,相关产品的交期将大幅缩短,从原本预估的5-6个月,压缩至2-3个月,台积电最快将在10月底至11月初向英伟达开始交货。

由此看来,NVIDIA在GTC 2022上宣布 NVIDIA H100 Tensor Core GPU全面投产,也算是对上述传闻的“表态”了。

为何如此着急?皆因在8月底,美国方面命令NVIDIA及AMD停止向中国大陆、中国香港和俄罗斯销售部分高性能GPU,其中就包括NVIDIA的A100和H100。

来源:网络

对此,NVIDIA与美国相关部门展开了积极斡旋,很快在9月1日,他们公告声明已获得美国政府批准,可以在明年3月前继续向美国客户出口(到中国)的产品提供A100,可以在明年9月前继续履行A100和H100的订单。

总的来说,考虑到中国是NVIDIA和AMD最重要的市场之一,美国方面决定给予禁售令最多1年的宽限期。而为了应对市场和出口管制政策的不确定因素,NVIDIA也要在这1年内尽可能多地保障客户长期需求,所以向台积电下“超级急件”订单,早些生产出明年出货的量,满足市场客户“囤货”的需求。