5月31日晚间,国产GPU厂商景嘉微发布公告称,拟向特定对象发行A股股票预案,募集资金总额不超过420,073万元,扣除发行费用后的募集资金净额将用于高性能通用GPU芯片研发及产业化项目、通用GPU先进架构研发中心建设项目。

公告显示,“高性能通用GPU芯片研发及产业化项目”将由景嘉微全资子公司长沙景美集成电路设计有限公司组织实施,总投资金额为378,123万元,自主开发面向图形处理和计算领域应用的高性能GPU芯片。意在实现国内游戏、专业图形渲染、数据中心、人工智能、自动驾驶等应用领域GPU芯片的国产替代。

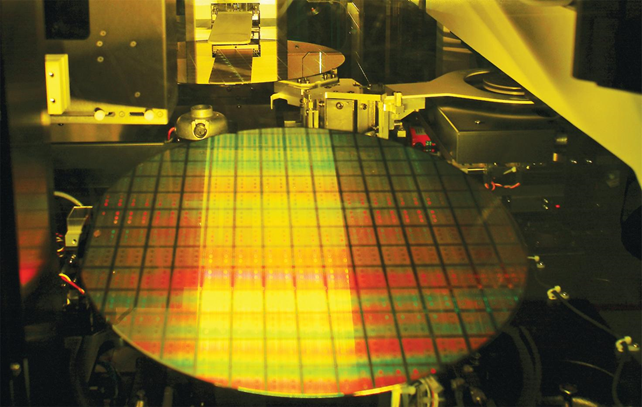

据介绍,该项目还将与第三方芯片封装测试厂商共建公司专用的封装测试生产线,由公司投资采购相关封装测试设备,第 三方厂商运营该设备并为公司后续开发的 GPU 产品提供封装测试服务。该项目实施完成后,公司将实现对先进封装工艺的产能绑定,一方面有利于 将先进封装工艺与高性能 GPU 产品研发高效结合,推动 GPU 产品突破前道制程 工艺限制,持续提升产品性能,从而增强产品竞争力;另一方面,有利于保证公 司 GPU 产品的交付周期、产量和品质的稳定性、可靠性,提高公司的业绩表现。

至于“通用GPU先进架构研发中心建设项目”,将由景嘉微全资子公司无锡锦之源电子科技有限公司组织实施,总投资金额为96,433万元,主要布局前瞻性技术领域,面向满足未来高性能计算和数据处理需求的重要方向,将在江苏省无锡市建设通用GPU先进架构研发中心。

GPU 封装:大算力时代下,被寄予厚望的 Chiplet

AIGC 算力大时代下,GPU 支撑强大的算力需求。GPU 即图形处理器(英语:graphics processing unit),又称显示核心、视觉处理器、显示芯片,可以兼容训练和推理,被广泛运用于人工智能等领域。作为AI 硬件的心脏,GPU 的市场被英伟达和 AMD 等海外巨头垄断。

ChatGPT 这样的生成式 AI 不仅需要千亿级的大模型,同时还需要有庞大的算力基础。训练 AI 现在主要依赖 NVIDIA 的 AI 加速卡,达到 ChatGPT 这种级别的至少需要 1 万张 A100 加速卡,而一颗英伟达顶级 GPU 单价高达 8 万元。

存算一体化突破算力瓶颈,GPU 封装进入正当时。在 AI 运算中,神经网络参数(权重、偏差、超参数和其他)需要存储在内存中,常规存储器与处理器之间的数据搬运速度慢,成为运算速度提升的瓶颈,且将数据搬运的功耗高。2016 年英伟达率先推出首款采用 CoWoS 封装的绘图芯片,为全球 AI 热潮拉开序幕。英伟达 H100 拥有 800 亿个晶体管,相比上一代的 A100,有着六倍的性能提升以及两倍的 MMA改进,采用的 CoWoS 2.5D 晶圆级封装。在算力芯片性能暴增的时代下,相关的封装产业链也逐渐的进入高速发展时期。

Chiplet 是后摩尔时代的半导体工艺发展方向之一。Chiplet 将大型单片芯片划分为一组具有单独功能的小芯片单元 die(裸片),小芯片根据需要使用不同的工艺节点制造,再通过跨芯片互联和封装技术进行封装级别集成,降低成本的同时获得更高的集成度。

Chiplet 技术要把原本单个大硅片“切”成多个再通过封装重新组装起来,而单个硅片上的布线密度和信号传输质量远高于 Chiplet 之间,这就要求必须发展出高密度、大带宽布线的先进封装技术,尽可能的提升在多个 Chiplet之间布线的数量并提升信号传输质量。支持Chiplet的底层封装技术目前主要由台积电、日月光、英特尔等公司主导,包含从 2D MCM 到 2.5D CoWoS、EMIB 和 3D Hybrid Bonding。

HBM与先进封装需求大涨

2023年ChatGPT引发的AI热潮仍在继续,近期媒体报道,今年拥有云端相关业务的企业,大多都向英伟达采购了大量GPU,目前该公司订单已排至2024年。

同时,由于英伟达大量急单涌入,晶圆代工企业台积电也从中受益。据悉,英伟达正向台积电紧急追单,这也令台积电5纳米制程产能利用率推高至接近满载。台积电正以超级急件(superhotrun)生产英伟达H100、A100等产品,而且订单排至年底。

业界认为,随着ChatGPT等AIGC(生成式人工智能)快速发展,未来市场对GPU的需求将不断上升,并将带动HBM以及先进封装发展。

资料显示,AIGC模型需要使用AI服务器进行训练与推理,其中,训练侧AI服务器基本需要采用中高端GPU,在这些GPU中,HBM的渗透率接近100%。

全球市场研究机构TrendForce集邦咨询预估2023年AI服务器(包含搭载GPU、FPGA、ASIC等)出货量近120万台,年增38.4%,占整体服务器出货量近9%。

从高端GPU搭载的HBM来看,英伟达高端GPU H100、A100主采HBM2e、HBM3。以今年H100 GPU来说,搭载HBM3技术规格,其中传输速度也较HBM2e快,可提升整体AI服务器系统运算效能。随着高端GPU如NVIDIA的A100、H100;AMD的MI200、MI300,以及Google自研的TPU等需求皆逐步提升,集邦咨询预估2023年HBM需求量将年增58%,2024年有望再成长约30%。

先进封装产能方面,当前台积电CoWoS封装技术为目前AI服务器芯片主力采用者。

集邦咨询估计在高端AI芯片及HBM强烈需求下,TSMC于2023年底CoWoS月产能有望达12K,其中,英伟达在A100及H100等相关AI Server需求带动下,对CoWoS产能较年初需求量,估提升近5成,加上AMD、Google等高端AI芯片需求成长下,将使下半年CoWoS产能较为紧迫,而此强劲需求将延续至2024年,预估若在相关设备齐备下,先进封装产能将再成长3-4成。