GPU Utils 发布了一份关于英伟达GPU——主要是H100的研究报告,试图梳理有关GPU供应和需求的相关问题。在这篇主要针对美国市场的报告中,我们看到了目前阻碍大模型和人工智能发展的关键瓶颈GPU短缺是如何形成和发展的。

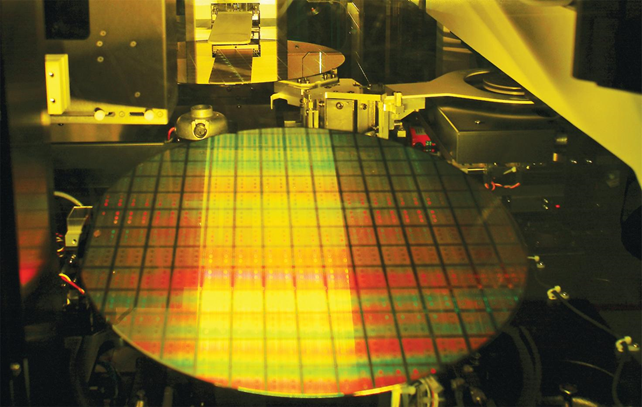

总的来说,GPU瓶颈的出现原因是多方面的,环环相扣的复杂工艺制造流程,半导体周期,对稀缺资源的抢占与恐慌乃至未曾预料到的人工智能的突然爆发,都让GPU算力变得无比紧张。

乐观地看,2024年这一瓶颈或许会有所缓解。

数十万张缺口,一百五十亿需求

每个想要在人工智能爆发中分一杯羹的人都需要GPU。准确地说,是英伟达的A100和H100,它们在训练和推理大模型中扮演关键角色。如果要想要从头训练大模型,至少需要上千张A100或H100,而推理和微调大模型也至少需要储存100张。

具体到每家的数量上,报告汇总了一些数据:GPT4在1万到2.5万块A100上训练,Meta有2.1万块A100,特斯拉有7000块,Stability AI有5000块,谷歌云大概有2.5万块H100,微软Azure 有1万到4万块,甲骨文可能也有同样多的H100。值得一提的是,Azure的GPU基本都用来供应OpenAI的训练了。

而根据马斯克的说法,GPT5的训练可能会用到3万到5万张H100,因此对未来的估计上,报告指出OpenAI可能需要5万张H100,Meta至少需要2.5万张(也有人说实际上需要10万乃至更多),所有的云服务厂商,微软、谷歌云和亚马逊云以及甲骨文各需要3万张,私有云服务商,比如刚刚融资的CoreWeave等总需求是10万张,而像Claude的开发者Anthropic这样的初创公司也都至少需要1万张GPU。

另外,一些金融公司比如JP Morgan等也在部署A100或H100,因此总体上看,对H100的需求超过了43万张。

这还是不算中国市场的情况,由于制裁原因,字节跳动、百度、腾讯和阿里巴巴只能大量购买A100和H100的替代产品A800与H800,这一部分的需求没有列入其中,根据《金融时报》的说法,其总额高达50亿美金。

如果将这些数字相加,这就是目前英伟达面对的,总计规模高达200亿美元的GPU需求。

GPU 短缺阻碍ChatGPT进步速度

据《财富》杂志报道,OpenAI 公司 CEO 山姆奥特曼在一场非公开会议上透露,GPU 的严重短缺阻碍了 ChatGPT 的进步。

报道称,奥特曼于 5 月会见了多位 App 开发者和初创公司的管理者。伦敦 AI 初创公司 Humanloop 的 CEO 拉扎哈比卜在一则推文中称,奥特曼认为 OpenAI 缺少足够的 GPU,这导致许多优化 ChatGPT 的工作被迫推迟。

哈比卜的会议记录显示,客户对 ChatGPT 最大的抱怨是 API 界面的速度和可靠性。奥特曼对此表示理解,并解释称主要原因是 GPU 严重不足。

会议记录公开后不久,OpenAI 联系了哈比卜,表示该活动不便公开发布。随后哈比卜删除了这则推文。据介绍,奥特曼抱怨了 GPU 短缺导致算力不足,OpenAI 无法扩大 ChatGPT 的对话框列表。这影响了 ChatGPT 在回答用户问题时可以处理的信息量,限制了 ChatGPT 的“记忆力”,如过往提问记录等。此外,ChatGPT 由于算力不足也无法完成更繁琐的任务,例如写出复杂的程序代码等。

算力租赁正在兴起

近期各AI厂商纷纷拿出大模型“秀肌肉”之时,多位观察人士告诉财联社记者,大数据、人工智能等领域的快速发展推动算力需求(特别是大模型和行业应用等方面)迅速增长。据了解,GPU需求旺盛并已陷入供应短缺。

“不像消费显卡,很多商家会有库存,它本来存货就很少,整个供应链上的货不超过三四千片,GPT热度起来以后就被互联网大厂全部锁完了,今年3月后市场上基本没有存货了,部分大厂开始直接从国外渠道找一些货回来,现在50%以上的订单基本都是互联网大厂下的。”张亚洲在接受财联社记者采访时表示。

张亚洲告诉记者,包括微软、英特尔等海外大厂一边自研、一边也在对外采购,他们前期订的一部分(GPU订单),可能用于大规模训练,对于推理还是不够的。基本上厂商低于一个亿的订单,也许渠道商都不愿搭理,发邮件都不回。”GPU的火爆程度由此可见一斑。

而从价格层面看,多款GPU价格从3、4月至今涨幅接近50%。张亚洲称,“4月份的时候(订单)大概还能排到10月份,现在已经到明年上半年了。”

鲸平台专家、鉴片工场创始人张力卜告诉财联社记者,“很多企业和个人都需要用到高性能的GPU来进行深度学习的训练和应用,但自己购买服务器建设数据中心的成本又很高,所以选择租赁云算力平台是比较划算和灵活的方式。”基于这一逻辑,租用计算资源的算力租赁模式当前正在兴起。

国内GPU应用三大市场

GPU应用场景不断扩大拉动GPU市场空间迅猛增长,根据VerifiedMarket Research预测,2027年中国GPU市场规模将会增长至345.57亿美元。

GPU市场主要应用场景可概括为:AI&数据中心、智能汽车、游戏。

I&数据中心:新一轮AI对算力需求远超以往:ChatGPT类语言大模型底层是2017年出现的Transformer架构,该架构相比传统的CNN/RNN为基础的AI模型,参数量达到数千亿,对算力消耗巨大,对算力硬件有大量需求。随着对商业数据和大数据处理要求算力的不断提高,GPU的通用计算能力正在越来越广泛地被应用与数据中心和国家超算中心的建设。

智能汽车:智能汽车方兴未艾,自动驾驶和智慧座舱是智能汽车发展的主要方向,均需大量使用GPU。

游戏:游戏业务是GPU应用的传统领域,对游戏画面进行3D渲染,英伟达的游戏业务稳中有进。

1、AI:数据中心和终端场景不断落地对计算芯片提出更多更高需求

依据部署位置划分,AI芯片可以细分为终端芯片和云端芯片,云端芯片市场空间越为终端芯片的2-3倍。

云端芯片:云端芯片应用于云端服务器,可以进一步细分为推理芯片和训练芯片。根据甲子光年数据,2018年中国云端芯片市场约46.1亿元,该机构预计2023年增长至384.6亿元。

终端芯片:应用于嵌入式、移动终端、智能制造、智能家居等领域的AI芯片,终端芯片需要低功耗和更高的能效比,但是对算力的需求也相对较低,主要应用与AI推理。根据甲子光年数据,2018年中国终端芯片市场约15亿元,该机构预计2023年增长至173亿元。

AI芯片总市场232亿元,其中云端芯片市场空间更大,预计终端芯片将随着AI在多行业落地将进一步放量。甲子光年预测,中国AI芯片市场规模将从2021年232亿元增长至2023年的500亿元左右,对应中国云端芯片市场的复合增长率为52.8%;终端芯片市场规模相对较小,但由于人工智能在汽车、安防、智能家居等行业渗透,届时市场规模增长率达到62.2%。

2、汽车智能化浪潮下汽车GPU市场前景广阔

自动驾驶

汽车智能化浪潮下,自动驾驶和智能座舱是最具有发展前景的两个方向,GPU应用于二者的域控制器,智能汽车主流的域控制器采用SoC与MCU结合的方案,SoC(片上系统)由GPU、CPU、AI引擎、DPU等组成。GPU在自动驾驶中的作用表现在图形处理和并行计算,ADAS平台可以利用GPU的并行计算能力实时分析来自激光雷达、雷达和红外摄像头的传感器数据。

盖世汽车预计到2025年中国自动驾驶域控制器出货量达到432万台,自动驾驶域控制器与SoC之比在1:1到1:4之间,市场份额较高的SoC通常搭载一片GPU。

智能座舱

GPU虚拟化技术助力智能座舱一芯多屏化发展,智能座舱芯片主要为SoC(片上系统),SoC由GPU、CPU、AI引擎、DPU等组成。智能座舱向着一芯多屏的形态发展,这对芯片并行计算的要求不断提高,GPU硬件虚拟化技术在智能座舱中有着无可替代的优势。在智能座舱屏幕、仪表盘、车载与各系统中均需要使用GPU。

盖世汽车预计2025年中国智能座舱域控制器出货量达到528万台,智能座舱一台域控制器内置一个SoC,位于汽车的中央显示屏内,一个SoC通常搭载一片GPU。

3、游戏玩家人数持续增长,游戏GPU市场规模稳中有升

游戏市场是传统意义上GPU最关键的市场,随着千禧一代游戏需求的进一步提升,全球游戏玩家数量稳增,相应地扩展了游戏GPU市场规模。NewzooExpert预计2020-2025年全球游戏玩家人数复合年增率为4.2%。

游戏GPU的主要分类:根据现行市场上的主要产品可划分为四类:1)游戏机、2)PC端主机游戏、3)控制台、4)VR&AR。根据JonPeddie Research统计,2021年Q4全球PCGPU出货量(包括集成和独立显卡)高达11000万片。受到俄乌冲突、天然气供应等冲击性全球事件影响,2022年Q1、Q2,全球PCGPU出货量略有下降。

由于PC正常运行必须要求硬件上同时具备CPU和GPU,因此每台PC至少需要一张集成显卡或独立显卡,此外,根据需求可再增购独立显卡。根据JPR统计,全球GPU与PC配售比在2022Q1达到了129%。