日前,在《金融时报》最近的一篇文章中,Nvidia 报告称,预计 2023 年将在全球范围内出货 550,000 个最新的 H100 GPU。对 GPU 的需求显然来自生成式 AI 热潮,但 HPC 市场也在争夺这些加速器。

大部分 GPU 将流向美国科技公司,但英国《金融时报》指出,沙特阿拉伯已经购买了至少 3,000 个 Nvidia H100 GPU,阿联酋也购买了数千个 Nvidia 芯片。

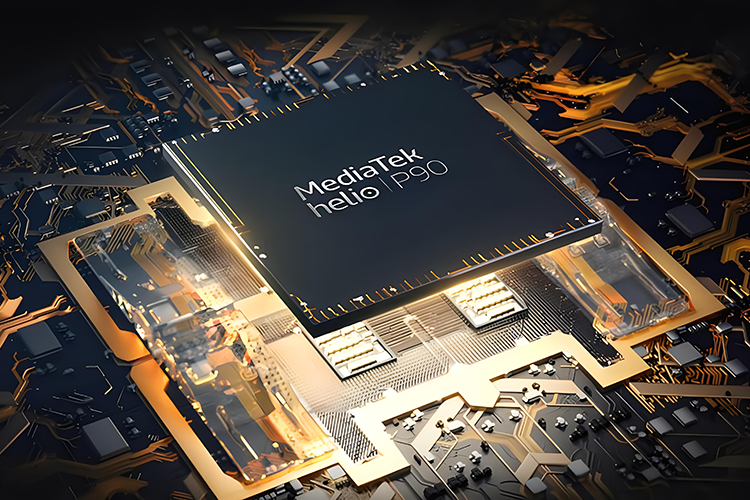

旗舰级 H100 GPU(14,592 个 CUDA 核心、80GB HBM3 容量、5,120 位内存总线)售价高达 30,000 美元(平均),Nvidia 首席执行官黄仁勋 (Jensen Huang) 称其为首款为生成式 AI 设计的芯片。

根据《巴伦周刊》资深撰稿人 Tae Kim最近在社交媒体上发布的估计,Nvidia 制造 H100 的成本为 3,320 美元。这让英伟达获得基于 Nvidia H100 卡零售成本的 1000% 利润。这意味着 Nvidia 的每个高性能计算 (HPC) 加速器(最便宜的 PCIe 版本)的市场价格约为 25,000 至 30,000 美元,超过了每个芯片和外设的估计成本 3,320 美元(在板)组件。

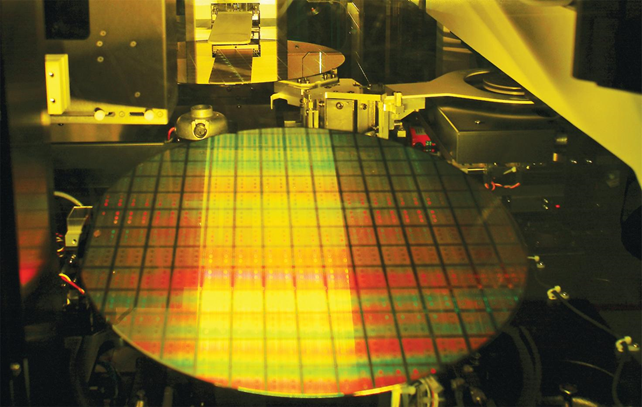

然而,目前尚不清楚成本分析有多深入:如果这是一个纯粹的制造成本问题(在考虑良率的情况下平均每片晶圆和其他组件的价格),那么 Nvidia 仍然需要支付大量的的额外费用。产品开发需要时间和资源;考虑到 H100 等产品的产品开发生命周期中的工程师和其他参与者,在得出最终的平均产品开发成本之前,还必须考虑 Nvidia 的研发成本。

即便如此,不可否认的是,作为人工智能加速工作负载的领先公司是有优势的。众所周知,Nvidia GPU 很快就被抢购一空,甚至连它们堆放的机架都没有接触过。这实际上意味着 Nvidia 人工智能加速产品的订单似乎已经售完到 2024 年。预计到 2027 年人工智能加速器市场价值将达到 1500 亿美元左右。