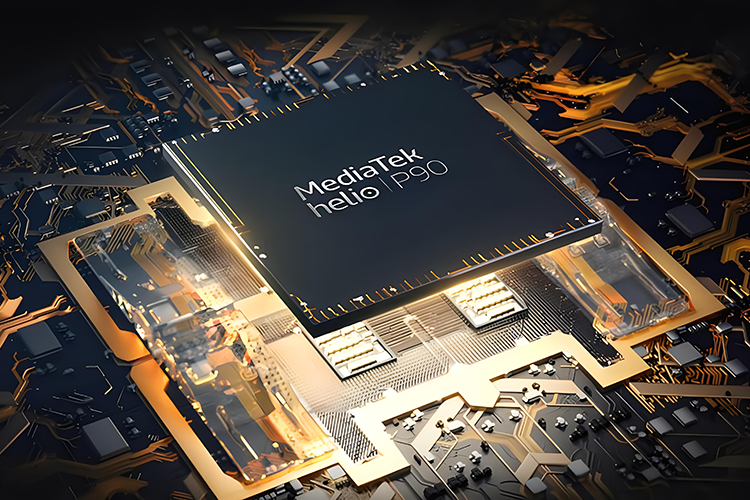

5月14日,英伟达一年一度的 GTC 大会在线上开幕。此次大会上,英伟达正式发布全新数据中心 GPU——NVIDIA A100,即此前在网上盛传的,被命名为安培(Ampere)的产品。英伟达创始人兼 CEO 黄仁勋在线上发布会上介绍称,其包含 540 亿晶体管,拥有比原来强大20倍的AI算力。

因为疫情的缘故,原本定在3月的发布会一推再推,两个月的时间没白等,英伟达终于带来了一道“硬菜”。

加血AI“引擎”

从烤箱里端出来的不一定是培根,也可以是“安培”。要说英伟达这次的线上发布会也是别出心裁,地点选在自家厨房,CEO黄仁勋从烤箱中将“主菜”端了出来,而这道菜就是“安培”,即Ampere架构GPU。

公司创始人兼 CEO 黄仁勋介绍称,NVIDIA Ampere 包含540亿晶体管,拥有比原来强大20倍的AI算力。“如果AI是跑车,数据就是燃料,而算力则是引擎”英伟达研发中心总经理王玮琦曾在接受《科创板日报》记者专访时说道。英伟此次也通过NVIDIA Ampere向业界宣布:我们的AI“引擎”很强大。

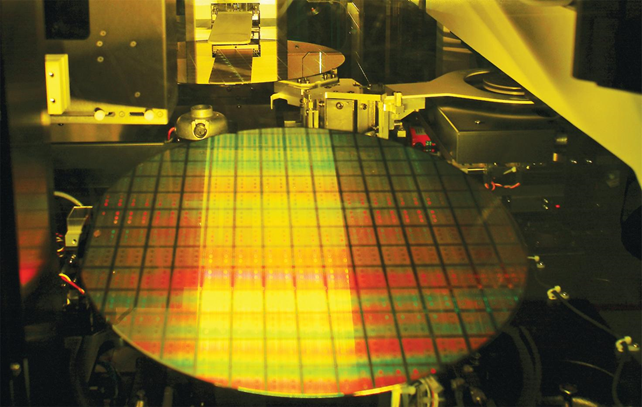

“有史以来最大的7纳米芯片”英伟达官网介绍显示,NVIDIA Ampere具有六项突破性的关键创新。

一是NVIDIA Volta™ 架构中率先采用的 NVIDIA Tensor Core 技术助力 AI 实现了大幅加速。NVIDIA Ampere 架构以这些创新为基础,通过引入新的精度 :Tensor 浮点运算 (TF32) 和 FP64 加速和简化 AI 技术采用,并将 Tensor Core 的强大功能扩展至 HPC。二是多实例 GPU (MIG)。借助 MIG,每个A100 可以划分成七个 GPU实例,在硬件级别上可实现完全安全、彼此隔离,并拥有自己的高带宽显存。

三是第三代NVIDIA® NVLink® 技术通过为多 GPU 系统配置提供更高的带宽、更多的链接和改进的可扩展性解决互连问题。两个 GPU 之间的直接通信链接加快了AI 训练工作负载的收敛速度和解决时间。

四是结构化稀疏,A100中的Tensor Core 可为稀疏模型提供高达 2 倍的性能提升。稀疏化功能对 AI 推理更为有益,也可用于改善模型训练的性能。五是A100正在为数据中心提供海量计算能力。其具有每秒 1.5TB 的显存带宽,比上一代高出 67%。此外,A100 的片上存储空间更大,包括 40MB的2级缓存(比上一代大 7 倍)。六是NVIDIA EGX™A100 结合了NVIDIA Ampere 架构和NVIDIA Mellanox的 ConnectX-6 Dx SmartNIC,为计算和网络功能加速,且可处理边缘端产生的大量数据。

完善AI产品生态

谈到AI计算力,就不得不提英伟达,业界公认其为AI时代计算力增长的“红利收割者”,而英伟达在AI上的野心不止于提供高性能“引擎”那么简单。

此次发布会上,英伟达还推出了两款计算平台,其一是适用于大型商业通用服务器的 EGX A100,据介绍,EGXA100 是基于安培架构的A100 GPU,每秒可接收高达200GB数据,并可将数据直接发送到 GPU 内存用来进行AI或5G 信号处理。二为适用于微型边缘服务器的 EGX Jetson Xavier NX 。EGX Jetson Xavier NX是被称作全球体积最小、性能最强大的Al超级计算机,适用于微型服务器和边缘智能物联网盒。

从英伟达在计算平台的布局来看,其在自动驾驶计算平台已经建立起从10TOPS/5W,200TOPS/45W到2000 TOPS/800W的完整产品线。在医疗领域NVIDIA Clara医疗平台曾在20分钟内分析了整个人类基因组的DNA序列,实现研究人员对病人对疾病的易感性、疾病的进展和对治疗的反应有了更深入的了解,构建了疾病监测AI模型,利用Clara城乡技术通过胸部CT扫描检测和研究COVID-19感染的严重程度,并开发新的工具来更好地理解、测量和检测感染。

这次发布会上,英伟达不仅带来了新一代安培架构,还推出包括GPU芯片、AI系统、服务器构建块、AI超级计算机、边缘服务器产品、嵌入式AI产品等全套AI计算“大礼包”。

赛迪顾问人工智能产业研究中心副总经理邹德宝在接受《中国电子报》记者采访时指出,英伟达从技术层、产品层、产业链层和供应链层均有布局,在构建生态上具有一定优势,也因此进一步奠定了其在业界的领先地位。

业内专家向记者指出,如何开发自己的生态,延长产业链,是企业提升自身综合竞争力的关键步骤,这是所有AI芯片公司从技术研发走向商业化落地都需要考虑的问题。